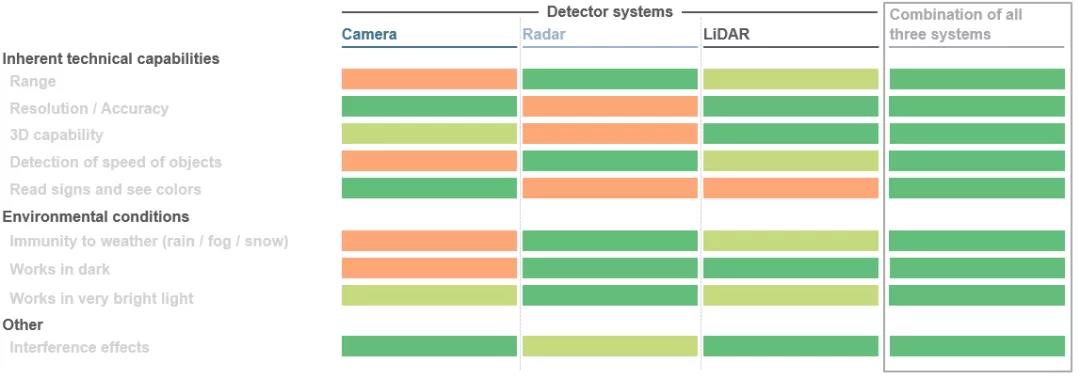

Một bước nhảy vọt khổng lồ đang diễn ra về tính di động. Điều này đúng cho dù trong lĩnh vực ô tô, nơi các giải pháp lái xe tự động đang được phát triển hay trong các ứng dụng công nghiệp sử dụng robot và các phương tiện dẫn đường tự động. Các thành phần khác nhau trong toàn bộ hệ thống phải hợp tác với nhau và bổ sung cho nhau. Mục tiêu chính là tạo ra một chế độ xem 3D liền mạch xung quanh xe, sử dụng hình ảnh này để tính toán khoảng cách đối tượng và bắt đầu chuyển động tiếp theo của xe với sự trợ giúp của các thuật toán đặc biệt. Trên thực tế, ba công nghệ cảm biến được sử dụng cùng lúc ở đây: LiDAR (LiDAR), radar và camera. Tùy thuộc vào từng trường hợp ứng dụng cụ thể, ba cảm biến này có những lợi thế riêng. Kết hợp những ưu điểm này với dữ liệu dự phòng có thể cải thiện đáng kể khả năng bảo mật. Các khía cạnh này được phối hợp càng tốt, xe tự lái sẽ có thể điều hướng môi trường của nó tốt hơn.

1. Thời gian bay trực tiếp (dToF):

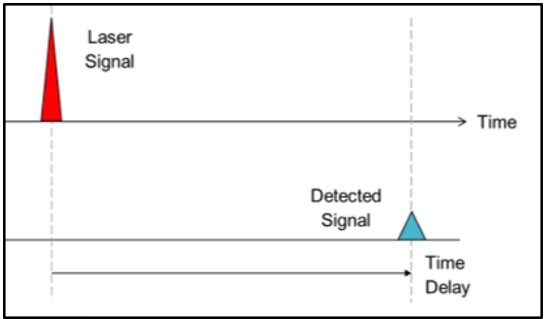

Trong phương pháp tiếp cận thời gian bay, các nhà sản xuất hệ thống sử dụng tốc độ ánh sáng để tạo ra thông tin về độ sâu. Nói tóm lại, xung ánh sáng có hướng được bắn vào môi trường, và khi xung ánh sáng chạm vào một vật thể, nó sẽ được phản xạ và ghi lại bởi một máy dò gần nguồn sáng. Bằng cách đo thời gian chùm tia tới đối tượng và quay trở lại, khoảng cách đối tượng có thể được xác định, trong khi trong phương pháp dToF, khoảng cách của một pixel đơn lẻ có thể được xác định. Các tín hiệu nhận được cuối cùng cũng được xử lý để kích hoạt các hành động tương ứng, chẳng hạn như di chuyển tránh xe để tránh va chạm với người đi bộ hoặc chướng ngại vật. Phương pháp này được gọi là thời gian bay trực tiếp (dToF) vì nó liên quan đến "thời gian bay" chính xác của chùm tia. Hệ thống LiDAR cho xe tự hành là một ví dụ điển hình của ứng dụng dToF.

2. Thời gian bay gián tiếp (iToF):

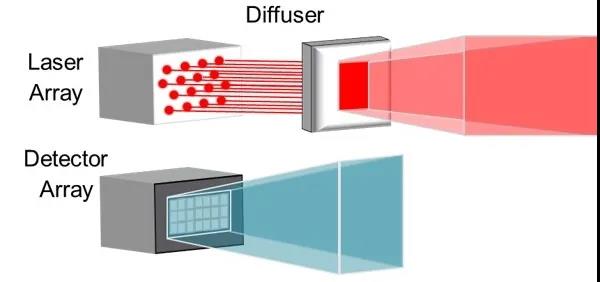

Cách tiếp cận thời gian bay gián tiếp (iToF) cũng tương tự, nhưng có một điểm khác biệt đáng chú ý. Ánh sáng từ nguồn sáng (thường là VCSEL hồng ngoại) được khuếch đại bởi một tấm tránh và các xung (chu kỳ làm việc 50%) được phát ra trong một trường nhìn xác định.

Trong hệ thống hạ lưu, một "tín hiệu tiêu chuẩn" được lưu trữ sẽ kích hoạt máy dò trong một khoảng thời gian nếu đèn không gặp vật cản. Nếu một đối tượng làm gián đoạn tín hiệu chuẩn này, hệ thống có thể xác định thông tin về độ sâu của từng pixel xác định của máy dò dựa trên sự dịch pha kết quả và độ trễ thời gian của tàu xung.

3. Tầm nhìn âm thanh nổi chủ động (ASV)

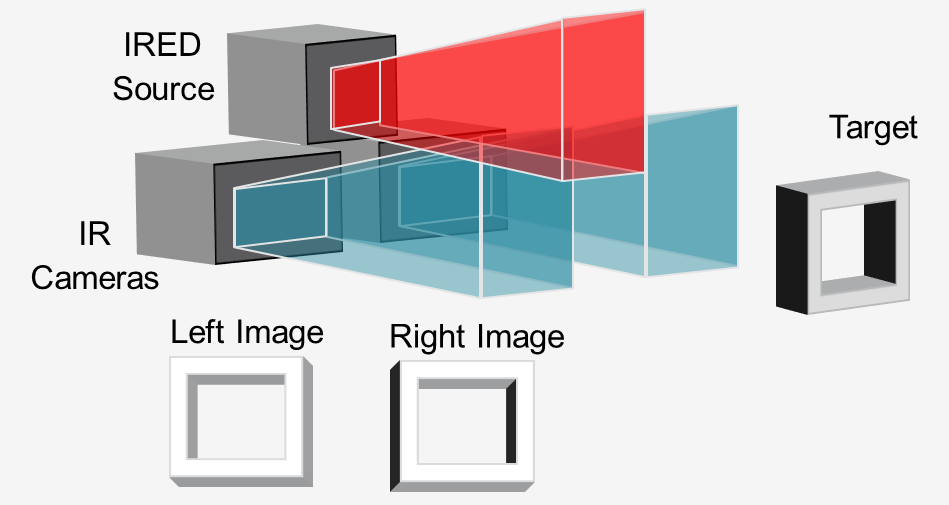

Trong phương pháp "tầm nhìn âm thanh nổi chủ động", nguồn sáng hồng ngoại (thường là VCSEL hoặc IRED) chiếu sáng cảnh bằng một mẫu và hai camera hồng ngoại ghi lại hình ảnh ở dạng âm thanh nổi.

Bằng cách so sánh hai hình ảnh, phần mềm hạ nguồn có thể tính toán thông tin độ sâu cần thiết. Đèn hỗ trợ tính toán độ sâu bằng cách chiếu một mẫu, ngay cả trên các vật thể có ít họa tiết như tường, sàn và bàn. Cách tiếp cận này lý tưởng cho cảm biến 3D ở cự ly gần, độ phân giải cao trên rô bốt và các phương tiện được dẫn đường tự động (AGV) để tránh chướng ngại vật.

Bản quyền @ 2020 Công ty TNHH Công nghệ Quang học Hộp Thâm Quyến - Mô-đun sợi quang Trung Quốc, Nhà sản xuất Laser ghép sợi quang, Nhà cung cấp linh kiện Laser Mọi quyền được bảo lưu.